El Término engañoso que todos usamos

Cuando escuchas que «ChatGPT recuerda tus conversaciones» o que «Claude tiene memoria», es fácil imaginar algo similar a la memoria humana. Neuronas almacenando recuerdos, un cerebro artificial guardando experiencias. Pero la realidad es completamente diferente.

Los LLMs no tienen memoria real. Lo que llamamos «memoria» en IA es simplemente un sistema de bases de datos que almacena información de conversaciones. Es momento de desmontar este término «fancy» y entender qué ocurre realmente.

Qué son realmente los LLMs: Máquinas sin memoria

Los modelos de lenguaje como GPT-4, Claude o Gemini son funciones matemáticas complejas. Procesan el texto que les proporcionas y generan una respuesta basándose en sus parámetros entrenados. Pero cuando termina esa respuesta, el modelo no retiene nada.

Cada interacción es aislada. Es como hablar con alguien que sufre amnesia instantánea después de cada frase. Sin sistemas adicionales, el modelo no «recuerda» que hace cinco minutos hablabas sobre arquitectura de software.

Esta es la razón por la que términos como «pensamiento», «razonamiento» o «memoria» aplicados a LLMs son metáforas. No hay neuronas biológicas, no hay almacenamiento de recuerdos, no hay consciencia procesando experiencias.

Cómo funciona la «Memoria» en aplicaciones de IA

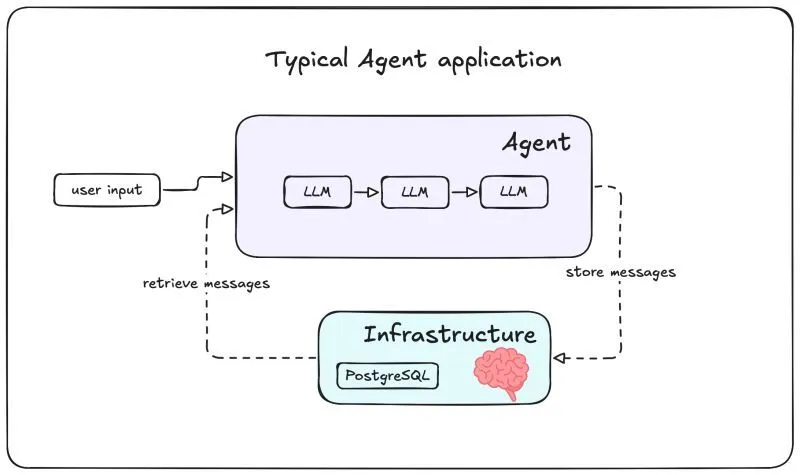

Lo que experimentas como «memoria» es ingeniería de sistemas. Cuando continúas una conversación, no es el modelo recordando, es una base de datos proporcionando contexto histórico en cada nueva solicitud.

El sistema más básico:

Una base de datos PostgreSQL conectada al agente. Cada mensaje que envías y cada respuesta se almacena. Cuando haces una nueva pregunta, el sistema recupera los últimos mensajes desde la base de datos, los incluye en el contexto que envía al LLM junto con tu pregunta, y el modelo genera una respuesta considerando toda esa información.

El LLM sigue sin recordar nada. Simplemente procesa un input más largo que incluye historial. Es como enviarle a alguien el transcript completo de tu conversación cada vez, permitiéndoles responder coherentemente sin realmente recordar nada.

Arquitecturas avanzadas de «memoria»

Desde ese sistema base puedes construir arquitecturas más sofisticadas:

Memoria a corto plazo: Almacena solo los últimos 10-20 mensajes de la conversación actual. Permite coherencia inmediata sin saturar el contexto.

Memoria a largo plazo: Usa bases de datos vectoriales como Pinecone o ChromaDB para almacenar información de todas las conversaciones históricas. El sistema busca semánticamente y recupera solo fragmentos relevantes.

Memoria semántica estructurada: Extrae y guarda hechos específicos del usuario: «prefiere comunicación concisa», «trabaja en finanzas», «proyecto actual: sistema de pagos». Esta información se inyecta selectivamente en conversaciones futuras.

Sistemas híbridos: Combinan múltiples tipos. Mensajes recientes en caché, información factual en bases relacionales, embeddings en bases vectoriales. Cada tipo optimizado para su propósito.

Por qué importa esta distinción

Para desarrolladores: Debes diseñar explícitamente sistemas de persistencia. El modelo no da «memoria» automáticamente. Necesitas decidir qué almacenar, dónde, por cuánto tiempo y cómo recuperarlo eficientemente.

Para usuarios: Si una conversación «olvida» información anterior, no es mala memoria del modelo. Es que el sistema de almacenamiento no recuperó esa información en el contexto actual.

Para privacidad: Tus conversaciones están literalmente almacenadas en servidores, no difusamente «recordadas». Esto tiene consecuencias sobre quién accede a esos datos.

Conclusión: Claridad en la Era de la IA

Términos como «memoria», «pensamiento» o «razonamiento» aplicados a LLMs son metáforas convenientes pero engañosas. Los modelos no recuerdan, no piensan, no razonan en el sentido humano.

La «memoria» de ChatGPT es PostgreSQL, Redis o Pinecone trabajando entre bastidores. No es menos impresionante que bases de datos inteligentes creen la ilusión de memoria, pero es fundamental entender qué ocurre realmente.

La próxima vez que un chatbot parezca «recordar» tu conversación anterior, sabrás la verdad: no hay neuronas almacenando recuerdos, solo ingeniería de software gestionando datos eficientemente.

¿Necesitas diseñar sistemas de memoria a corto o largo plazo para tu aplicación de IA? Contáctanos y construye soluciones robustas.