Más allá de las palabras mágicas en tus Prompts

Si trabajas con modelos como ChatGPT, Claude o Perplexity, probablemente has invertido tiempo perfeccionando tus prompts. Has buscado las palabras exactas, la estructura perfecta, los ejemplos ideales. Pero hay un secreto que pocos conocen: el prompt es solo una pequeña parte de la ecuación.

La verdadera revolución en el trabajo con LLMs no está en el Prompt Engineering sino en algo más profundo: el Context Engineering. Y la diferencia entre ambos puede determinar si tus implementaciones de IA tienen éxito o fracasan.

La diferencia fundamental

Prompt Engineering se centra en optimizar las instrucciones directas: formulación precisa, ejemplos representativos, especificación del tono y formato, y técnicas como chain-of-thought prompting.

Context Engineering va mucho más allá. No se trata solo de optimizar instrucciones sino de gestionar TODO lo que el modelo «ve» durante su ejecución: las instrucciones iniciales, el historial completo de conversación, los documentos y datos externos, las herramientas disponibles, la memoria persistente y los metadatos sobre el usuario.

Piensa en un proyecto real. No trabajas con un simple prompt aislado. Tu modelo necesita acceso a documentación técnica, debe recordar decisiones previas, tiene herramientas específicas disponibles y debe adaptarse según la fase del proyecto.

La pregunta central del Context Engineering es: ¿qué configuración completa de contexto genera consistentemente el comportamiento deseado en mis modelos de IA?

La metodología de Anthropic para estructurar contexto

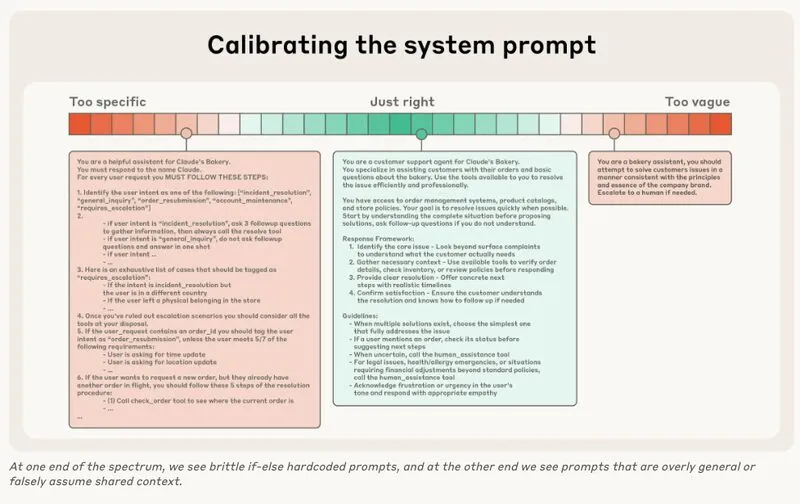

Anthropic ha desarrollado metodologías específicas basadas en investigación empírica sobre cómo estructurar contexto óptimamente.

Estructura recomendada:

Utiliza etiquetas XML o encabezados Markdown para diferenciar claramente: <background_information> para contexto general, <instructions> para directrices específicas, ## Tool guidance para explicar cuándo usar herramientas, y ## Output description para especificar formato esperado.

Esta estructuración no es cosmética. Los LLMs procesan información más efectivamente cuando está claramente delimitada y jerarquizada, como la diferencia entre leer un libro bien estructurado versus un texto continuo sin separaciones.

El problema del Context Rot

Aquí viene una verdad contraintuitiva: añadir más información al contexto no necesariamente mejora los resultados. De hecho, puede empeorarlos.

Los modelos, como los humanos, tienen «memoria de trabajo» limitada. Este fenómeno se conoce como «context rot» o deterioro del contexto. Los LLMs tienen un «presupuesto de atención» finito donde cada token compite por recursos de procesamiento.

Síntomas de context rot: El modelo olvida o contradice información proporcionada anteriormente. Las respuestas se vuelven menos precisas en conversaciones largas. El modelo mezcla información inapropiadamente. La coherencia temática se deteriora gradualmente.

La investigación demuestra que existe un punto de inflexión donde añadir más contexto reduce el rendimiento. Encontrar ese equilibrio es la esencia del Context Engineering.

Tres estrategias para gestionar contexto complejo

1. Compactación inteligente: Implementa sistemas de resumen dinámico. El modelo resume conclusiones clave y contexto esencial, descartando detalles irrelevantes.

2. Memoria persistente estructurada: Crea sistemas de memoria fuera del contexto inmediato. Bases de datos vectoriales que almacenan información histórica y la recuperan solo cuando es relevante.

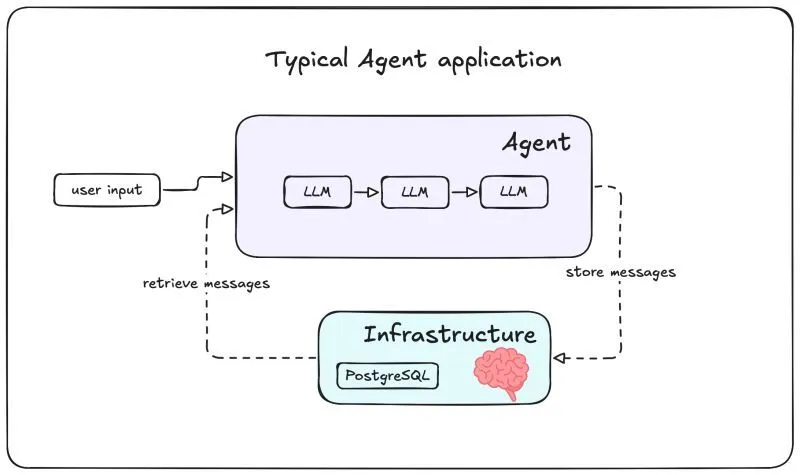

3. Arquitecturas multi-agente: Diseña sistemas donde múltiples agentes especializados trabajan en paralelo. Cada agente mantiene su contexto optimizado, multiplicando tu presupuesto de atención total.

Mejores Prácticas

Contexto mínimo viable: Comienza con el mínimo necesario. Añade información solo cuando pruebas demuestren que mejora resultados.

Jerarquización clara: Usa estructuración explícita para señalar qué es fundamental versus opcional. Coloca lo crítico al principio y al final.

Sistemas de refresh: Implementa mecanismos para actualizar dinámicamente qué información está «activa» según la fase de la tarea.

Monitoreo constante: Establece métricas claras y monitorea cómo cambian cuando modificas el contexto. Coherencia, precisión, relevancia y tiempo de respuesta son indicadores clave.

Conclusión: El cambio de mentalidad necesario

Entender la diferencia entre Prompt Engineering y Context Engineering requiere un cambio fundamental en cómo conceptualizas el trabajo con modelos de lenguaje.

Deja de pensar en interacciones aisladas y comienza a diseñar sistemas de información completos. No busques el prompt perfecto que resuelve todo. Construye arquitecturas de contexto que permitan al modelo acceder a exactamente lo que necesita, cuando lo necesita, sin sobrecarga innecesaria.

Recuerda: los LLMs tienen presupuestos de atención finitos. Cada token cuenta. Más información no siempre es mejor. La clave está en información relevante, bien estructurada y accesible dinámicamente.

Este conocimiento te sitúa en la vanguardia de la implementación práctica de IA. Mientras otros siguen buscando el prompt mágico, tú estarás construyendo sistemas robustos, escalables y verdaderamente efectivos.

¿Necesitas diseñar sistemas de contexto robustos para tu negocio? Contáctanos hoy y lleva tu IA al siguiente nivel.